生成AIの普及により、ビジネスにおけるAI活用は爆発的に進展しています。一方で、ハルシネーション(もっともらしい嘘)や権利侵害といった新たなリスクも顕在化しており、企業には「AIガバナンス」の構築が急務となっています。

本記事では、経済産業省・総務省が策定した最新の「AI事業者ガイドライン(第1.1版)」等の内容を紐解きながら、AIガバナンスを実践する上でボトルネックとなりがちな運用課題と、それを解決するBPOソリューション(投稿監視、運用サポート等)の有効性について解説します。

AIガバナンスとは?

AIガバナンスの定義と目的

AIガバナンスとは、「AIの利活用によって生じるリスクをステークホルダーにとって受容可能な水準で管理しつつ、そこからもたらされる正のインパクト(便益)を最大化することを目的とする、技術的、組織的、及び社会的システムの設計及び運用」と定義されています。 単にリスクを抑え込むだけでなく、「イノベーションの促進」と「社会的価値の実現」の両立を目指す点が重要です。

日本のAIガバナンスの3つの基本柱

日本のAIガバナンスは、以下の3つの概念を柱として設計されています。

- ゴールベース・アプローチ

細かな手順を定めるのではなく、最終的に達成すべき価値(ゴール)を示し、手段は企業の創意工夫に委ねる考え方です。 - リスクベース・アプローチ

すべてを一律に規制するのではなく、リスクの大きさ(危害の大きさと蓋然性)に応じて対策のレベルを調整するアプローチです。 - アジャイル・ガバナンス

環境は常に変化するため、一度ルールを決めて終わりではなく、「環境・リスク分析」→「ゴール設定」→「システムデザイン」→「運用」→「評価」のサイクルを継続的に回し続けることが求められます。

これらの柱が意味するのは、「企業ごとに、自社のリスクに見合った独自のガバナンス体制を自らデザインしなければならない」ということです。一律の「正解」がないからこそ、各社には「自社がAIのバリューチェーンのどこに位置し、どのようなリスクを負っているか」を正確に把握する高い自己管理能力が求められています。

AIガバナンスの3つの主体と役割

2025年3月公表の「AI事業者ガイドライン」では、AIに関わる事業者を以下の3つに分類しています。

- AI開発者 (AI Developer)

AIモデルやアルゴリズムを開発する事業者。 - AI提供者 (AI Provider)

AIシステムを製品やサービスに組み込んで提供する事業者。 - AI利用者 (AI Business User)

事業活動においてAIシステム・サービスを利用する事業者。

AIのリスクは、一社のみで完結するものではありません。開発者が安全なモデルを作っても、利用者が誤った使い方をすれば事故に繋がります。逆に、利用者が注意を払っていても、提供者からの情報開示が不十分であればリスクは防げません。

つまり、「自社の責任範囲(どこまで守るべきか)」と「他者への要求事項(どこから情報を得るべきか)」を明確に切り分けることが、バリューチェーン全体でのリスク管理において不可欠なのです。特に多くの企業が該当する「AI利用者」においては、開発や提供のプロセスがブラックボックス化しやすいため、後述するような「運用現場での監視・チェック」がガバナンスの生命線となります。

AIガバナンスの運用課題と具体的ソリューション

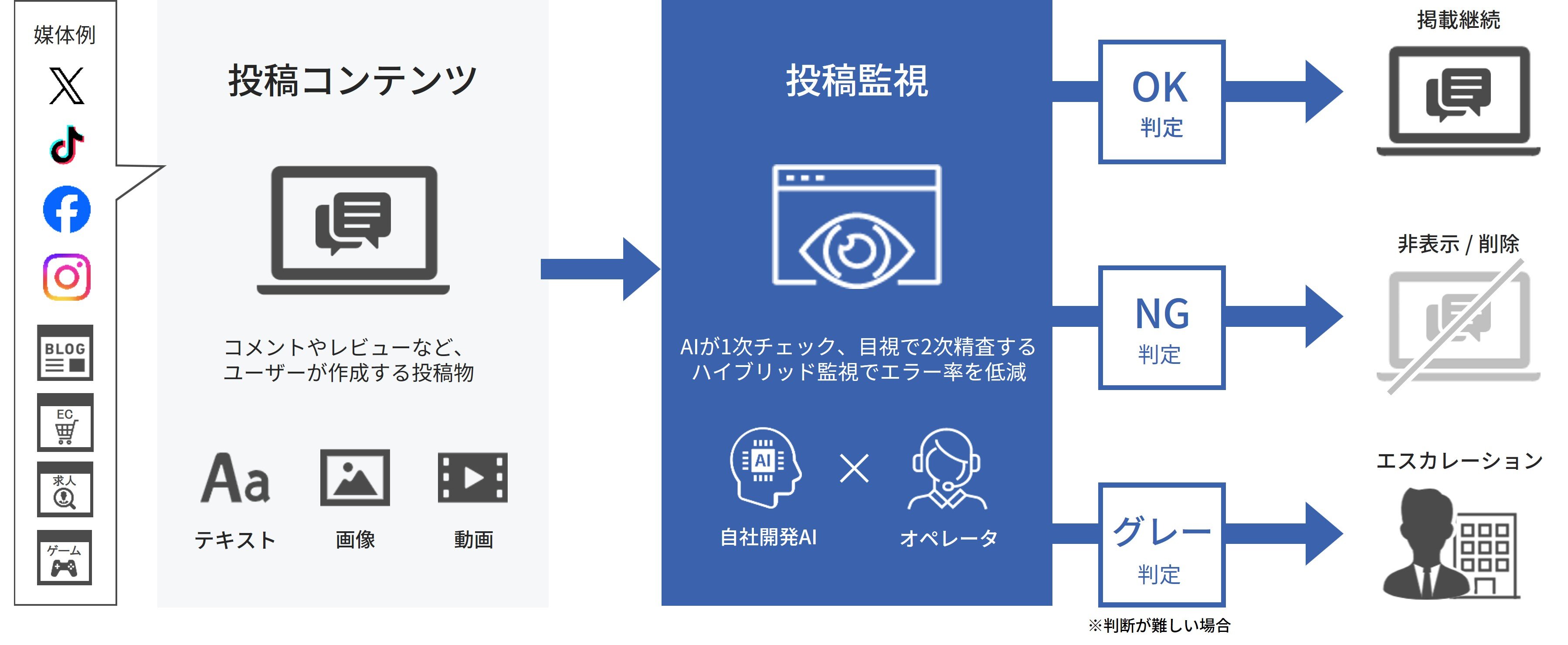

AIガバナンスを絵に描いた餅にしないためには、日々の運用プロセスに落とし込む必要があります。しかし、社内リソースだけで24時間365日の監視や高度な判断を行うことは困難です。 ここで有効なのが、私たちイー・ガーディアンが提供するような専門的なBPO(ビジネス・プロセス・アウトソーシング)サービスです。ガイドラインの要請事項に対し、これらのサービスがどのようにソリューションとなるかを見ていきます。

課題①:AI生成物の品質管理とハルシネーション対策

【ガイドラインの要請】

AIはハルシネーションを起こすリスクがあり、また偽情報・誤情報が社会を混乱させるリスクがあります。そのため、AIの出力結果を人間が鵜吞みにせず、適切なタイミングで「人間の判断を介在させる(Human-in-the-loop)」等の対策を講じることが重要とされています。

「Human-in-the-loop」に関して詳しく解説した記事も公開しておりますので、ぜひご覧ください。 【関連記事:AIガバナンスを形にする「Human-in-the-loop」実装ガイド】

【ソリューション:有人監視・アノテーション】

AIの出力結果をそのままユーザーに提示するのではなく、専門スタッフによる「有人監視(モニタリング)」を挟むことで、誤情報や不適切な表現をフィルタリングすることが可能です。 イー・ガーディアンの投稿監視サービスやBPOは、長年のSNS監視で培ったノウハウを活かし、AIが生成したテキストや画像がコンプライアンスや倫理基準に適合しているかを人間がチェックする体制を提供します。これにより、企業はガイドラインが求める「適正利用」を担保できます。

課題②:アカウンタビリティ(説明責任)と利用者対応

【ガイドラインの要請】

AI提供者や利用者は、ステークホルダーからの問い合わせに対応する窓口を設置し、AIの機能やリスクについて適切に説明・対応することが求められています。また、問題発生時には速やかに対応する体制(インシデント対応)が必要です。

【ソリューション:カスタマーサポート・運用代行】

AIサービス専用のカスタマーサポートを設置し、ユーザーからの「AIの回答がおかしい」「権利侵害ではないか」といった問い合わせに迅速に対応する体制を構築します。 専門のオペレーターが窓口となることで、ガイドラインが重視する「透明性」と「アカウンタビリティ」を確保し、企業の信頼性を維持することができます。

課題③:セキュリティと脆弱性対策

【ガイドラインの要請】

AIシステムに対する攻撃手法は日々進化しており、開発・提供・利用の各段階でセキュリティ対策を講じることが求められています。特に、敵対的攻撃やモデルへの不正侵入などのAI特有の脆弱性を特定し、緩和する必要があります。

【ソリューション:セキュリティ診断】

従来のシステムセキュリティに加え、AI特有の脆弱性も診断できるセキュリティ診断サービスの活用が有効です。 ガイドラインでも、レッドチーム(攻撃者視点でのテスト)などの手法を用いて、導入前および市場投入前にリスクを評価することが推奨されています。私たちイー・ガーディアングループのような専門企業による診断を受けることで、事業者は客観的なエビデンスを持ってセキュリティ基準を満たすことができます。

AIガバナンスの取り組みをはじめるにあたり

AIガバナンスの構築は、以下のステップで進めることが推奨されます。

- 環境・リスク分析

自社のAI活用がもたらす便益とリスクを洗い出す。 - ゴール設定

AIポリシー(指針)を策定する。 - システムデザイン

リスクに応じた管理体制やガイドラインとの乖離評価プロセスを構築する。 - 運用・評価

実際に運用し、モニタリングを行い、継続的に改善する。

イー・ガーディアングループでは、ハルシネーション対策からセキュリティ診断まで、ガイドラインの要請に応える多角的なソリューションを展開しております。AIの可能性を最大限に引き出し、持続可能な活用を実現するための一助として、弊社の知見をご活用いただけますと幸いです。AIガバナンスの運用体制構築に課題をお持ちの際は、ぜひお気軽にご相談ください。

■投稿監視サービス詳細はこちら

■ カスタマーサポートサービス詳細はこちら

■ セキュリティサービス一覧はこちら

<参考資料一覧>

本記事は、経済産業省および総務省が公表している以下のガイドラインおよび報告書に基づき作成しています。

・AI事業者ガイドライン(第1.1版)

・AI事業者ガイドライン(第1.1版) 別添(付属資料)

・AI原則実践のためのガバナンス・ガイドライン Ver. 1.1

・我が国のAIガバナンスの在り方 ver. 1.1

・AI・データの利用に関する契約ガイドライン 1.1版